La cantidad de procesos que tienen lugar en el desarrollo de una tarea determinada, como simplemente tomar una taza de café para comenzar nuestro día, es sorprendente. Dejando a un lado la toma de decisiones involucrada en obtener un buen grano y prepararlo a nuestro gusto, simplemente levantar esa taza no es un logro pequeño. Para llevar a cabo movimientos dirigidos a un objetivo, la corteza motora del cerebro debe recibir primero varios tipos de información de sus diversos lóbulos: información sobre la posición del cuerpo en el espacio, sobre el objetivo que se debe alcanzar y una estrategia adecuada para lograrlo, recuerdos de estrategias pasadas, y así sucesivamente.

Este es el tipo de proeza de habilidades motoras en la que está trabajando el investigador de robótica Gideon Billings, tratando de entrenar a los algoritmos que controlarán robots en el futuro. Cuando llegue el día en que se lancen robots para llevar a cabo de forma autónoma las misiones en entornos difíciles, tendrán que ser capaces de discernir qué herramientas usar y cómo usarlas. La clave para llegar allí es dividir ese desafío titánico en segmentos más pequeños. El enfoque de Billings es el aspecto visual de interactuar con herramientas.

Durante las inmersiones del ROV SuBastian, él ha podido recopilar conjuntos de datos útiles, que insertará en un algoritmo para que los robots puedan manipular diferentes herramientas de una manera óptima. “Mi conjunto de datos se enfoca en la detección de asas”, explica, “una vez que el robot identifica con éxito un asa, se le puede adjuntar cualquier herramienta y usar el conocimiento previo, como ‘Sé que este asa está conectada a una pala’ para decidir cómo usar la herramienta dentro de una escena particular “.

Poco a poco

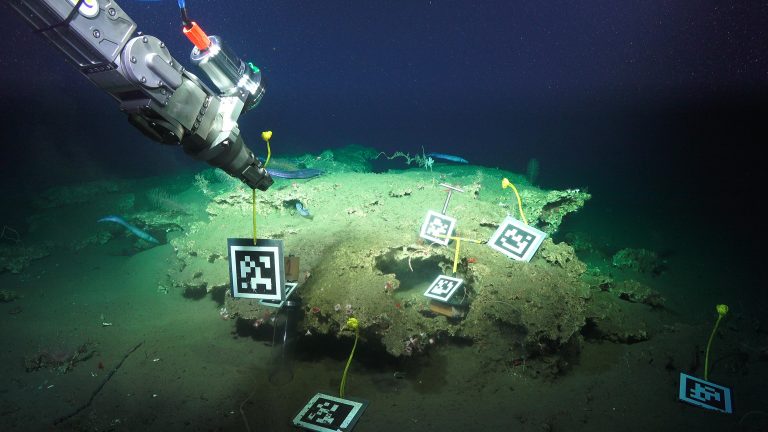

Una cosa es que un robot detecte qué tipo de asa se encuentra frente a él. Otra es estimar su posición en una escena determinada, recogerla automáticamente y usarla correctamente. Para aportar este conocimiento al algoritmo, Billings está aprovechando AprilTags, que son esencialmente códigos QR impresos en superficies cuadradas. Los AprilTags se puede utilizar en el desarrollo de experiencias de realidad aumentada, calibración de cámaras y, por supuesto, en robótica. “Puedes detectar estas pantallas en una imagen y dado que sabes cómo se ven, puedes determinar su posición y orientación 3D por su tamaño”, Billings dice, “también puedes obtener el ID de la etiqueta, que está asociado a un objeto específico” .

Inmersión tras inmersión, Gideon Billings recopila imágenes de las AprilTags desde diferentes ángulos, utilizando la cámara de ojo de pez instalada en uno de los brazos de SuBastian. Así es como, poco a poco, el equipo puede entrenar sus algoritmos para saber cómo se ven ciertos objetos en una escena en particular, dónde están y cómo interactuar con ellos.

La historia completa

Ya que está aquí, Billings está aprovechando las inmersiones de SuBastian para recopilar también conjuntos de datos que serán útiles en el desarrollo de otras tareas, como la reconstrucción de escenas.

Parecido al sistema de cámaras de seguridad en algunos automóviles una vez que se activa la reversa, que muestra una imagen de la escena en una pantalla, para ayudar al conductor a maniobrar sin chocar con ningún objeto cercano. “La reconstrucción de la escena es un objetivo más amplio dentro del panorama final”, dice Billings. “Es la historia completa: la reconstrucción de la escena, la identificación del objeto en la escena, la planificación alrededor de las obstrucciones de la escena y luego la decisión de cómo tomar los objetos”. La reconstrucción de la escena sería un paso intermedio diseñado para ayudar a los pilotos de ROVs, mostraría un modelo renderizado por computadora del vehículo dentro de la escena, proporcionando a los pilotos una visualización en 3D para ayudarlos a mover los brazos del vehículo y realizar un agarre, especialmente en lugares estrechos, alertándolos cuando estén a punto de golpear algo o estén cerca de una obstrucción.

Eso no es todo. Las grabaciones de las conversaciones entre los científicos y los pilotos informarán al algoritmo sobre los procesos de pensamiento involucrados en la selección de ciertos objetos o características interesantes. Incluso los movimientos oculares y el enfoque del piloto se documentan utilizando un lentes especiales de seguimiento del ojo, mientras controlan los brazos manipuladores del ROV.

Todos estos conjuntos de datos son ladrillos fundamentales en la construcción de inteligencia artificial robusta, que un día podrá explorar los océanos e incluso otros mundos acuáticos en nuestro sistema solar. Sin embargo, los robots primero deben aprender habilidades muy básicas para poder desarrollarse a partir de ellas. Primero necesitan gatear, antes de que puedan comenzar a caminar.